研究テーマ

北海道大学ヒューマンコンピュータインタラクションは以下のようなテーマを中心に研究を行いつつも、まだ言語化されていないような新しい概念の創出に向けて日々研究を行っています。

概要

北海道大学大学院情報科学研究院ヒューマンコンピュータインタラクション(HCI)研究室では、インタラクションデザインをキーワードとして、ロボットやエージェントのような対話システムのデザイン、新しいユーザインタフェースのデザインに関する研究を行ってきています。

Human-Agent Interaction (HAI)

Human-Robot Interaction (HRI)

人型ロボットのような社会的ロボットや、お掃除ロボットのような家庭用ロボット、Googleアシスタント / Apple Siri / Amazon Alexaのような音声対話エージェントが徐々に社会に普及し始めています。コンピュータの歴史を振り返って見たとき、大きく研究が発展したのはコンピュータが社会に普及し始めたときであり、その発展にはヒューマンコンピュータインタラクション研究が大きく貢献しました。同様に、社会への普及が始まったロボットや、エージェントには「人とのインタラクション」に関する研究が不可欠であり、それがヒューマンロボットインタラクション(HRI)やヒューマンエージェントインタラクション(HAI)と呼ばれる研究です。

HRIやHAIは、ロボットやエージェントと言った「人と関わり合う機械や仮想的なキャラクター」のインタラクションのデザインと工学的な実装や、インタラクションの社会的、心理的、認知的な影響を行動科学の方法論で理解に関する研究領域です。ロボットやエージェントは人間を含む動物に近い外見を有するものも多く、このため、それを見る人や、いまからコミュニケーションしようとする人は「きっと人間や動物と同じようにコミュニケーションができるだろう」と考えます。しかし、いまの技術では人間や他の動物と同じようにコミュニケーションすることができるロボットやエージェントは存在しません。このため、現状のロボットやエージェントの技術で、どのように対話(インタラクション)すれば自然な対話になるのか、その理解と実装が一つの研究テーマです。また、ロボットやエージェントと対話する人間や動物が、どのようにロボットやエージェントを認知するのか、そのコミュニケーションの社会的、心理学的な影響はどのようなものか、そもそも人や動物がロボットやエージェントをどのように認知するのか。それらの全てが研究テーマであり、また、これらの理解なしに「社会に受容されるロボットやエージェントの実現」は難しいと考えています。

当研究室では両研究分野の黎明期から研究を行ってきた教員が在籍しており、特に小野教授はHAIを代表するコミュニティである国際会議HAI ConferenceのSteering Committee chairを務めており、坂本准教授はHRIを代表するコミュニティである国際会議ACM/IEEE HRIのGeneral co-chairを務めた経験があります。日本国内においてもHAIやHRIを代表するシンポジウムであるHAIシンポジウムでの発表実績が多数あり、当研究室は両分野において日本を代表する研究室の一つであると言えます。

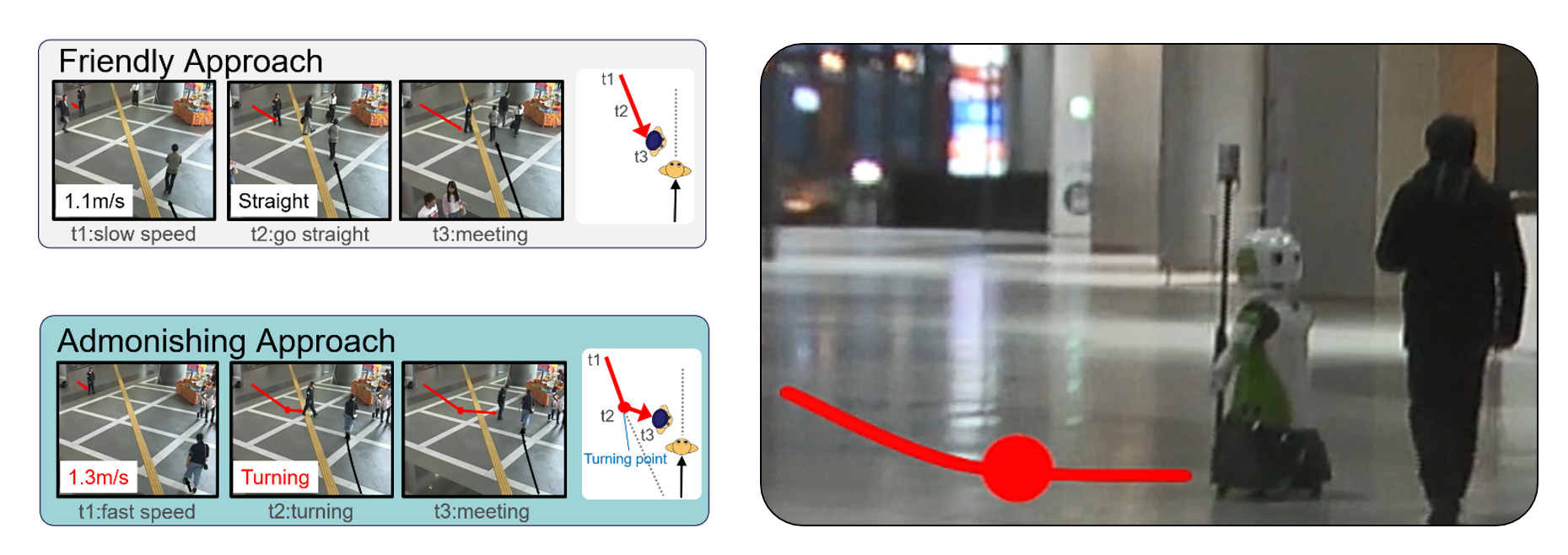

Stop doing it! Approaching Strategy for a Robot to Admonish Pedestrians

Kazuki Mizumaru, Satoru Satake, Takayuki Kanda, Tetsuo Ono

2019 14th ACM/IEEE International Conference on Human-Robot Interaction (HRI)

We modeled a robot's approaching behavior for giving admonishment. We started by analyzing human behaviors. We conducted a data collection in which a guard approached others in two ways: 1) for admonishment, and 2) for a friendly purpose. We analyzed the difference between the admonishing approach and the friendly approach. The approaching trajectories in the two approaching types are similar; nevertheless, there are two subtle differences. First, the admonishing approach is slightly faster (1.3 m/sec) than the friendly approach (1.1 m/sec). Second, at the end of the approach, there is a `shortcut' in the trajectory. We implemented this model of the admonishing approach into a robot. Finally, we conducted a field experiment to verify the effectiveness of the model. A robot is used to admonish people who were using a smartphone while walking. The result shows that significantly more people yield to admonishment from a robot using the proposed method than from a robot using the friendly approach method.

A Subtle Effect of Inducing Positive Words by Playing Web-Based Word Chain Game

Naoki Osaka, Kazuki Mizumaru, Daisuke Sakamoto, and Tetsuo Ono.

9th International Conference on Human-Agent Interaction (HAI '21).

A variety of chatbots were developed to elicit people’s emotional responses and manage the emotions of people. These chatbots often use text-based emotional sentences. However, there are few studies that chatbots use extremely simplified communications to induce some emotional responses. We investigated the effect of mood contagion and tried to induce positive or negative words from people on our web-based ”word chain game” system as the most simplified conversational style. We also defined the system’s emotion as making the system use words that have polarity, which means each word’s strength of positive or negative emotion. The result shows that users of the system using positive words were slightly influenced to use more positive words than the neutral or negative system.

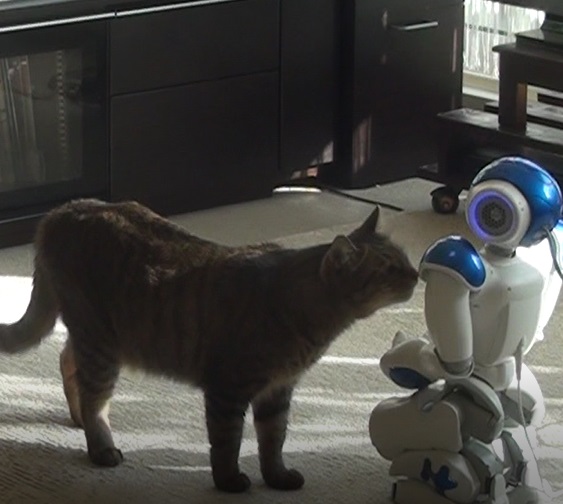

A Social Robot in a Human-Animal Relationship at Home: A Field Study

Haruka Kasuga, Daisuke Sakamoto, Nagisa Munekata, and Tetsuo Ono.

5th International Conference on Human Agent Interaction (HAI '17)

Pets are humanity’s oldest friend since ancient times. People have been living with them since then, and the relationship between people and pets as family members at home is well researched. Recently, social robots are entering family lives, and a new research field is being born, namely, a triad relationship between people, pets, and social robots. To investigate how a social robot affects a human-animal relationship in the home, an exploratory field experiment was conducted. In this experiment, a robot, called NAO, was introduced into the homes of 10 families, and 22 participants (with 12 pets: 4 dogs and 8 cats), called “owners” hereafter, were asked to interact with NAO. NAO was operated under two conditions: speaking positively to the pets, and speaking negatively to them. Just five sentenses that NAO spoke to the pets and two sentenses to the owners were different. The results of the study show that changing NAO’s attitude to the pets affected both the owners’ impression of the robot and the pet’s impression of the robot (perceived by the owners).

インタラクションデザイン / Interaction Design

ユーザインタフェース / User Interface

OECD(経済協力開発機構)の調査によれば、コンピュータを良く使えるのは先進国全体の人口比で5%程度であると言われており、いまだ多くの人がコンピュータを「使える」とは言えない状態にあります。一方で、それは人間の能力が足りないと考えるよりは、コンピュータが人間のために作られていないと考えるほうが自然です。それでは、

どうすればコンピュータを人々の生活に役に立つ道具とすることができるのか。

それを考えるのが我々の研究テーマであり、ユーザインタフェースやインタラクションデザインという研究です。我々のユーザインタフェースやインタラクションデザインに関する研究によって「使えない」を「使える」に変えていくことができると考えています。コンピュータによって「できる」ことが増えれば、人々が得られる情報は増え、生活範囲が広がり、社会的・文化的な知識や活動を増やすことができます。この変化によって人々の生活の質(Quolity of Life; QoL)を向上させることができるでしょう。コンピュータによるQoLの向上はHCI研究の根源的な研究課題であり、我々は常にこれを意識して研究を行ってきています。

HCI領域における研究テーマは、古くはオフィスオートメーション(自動化)から始まり、パソコン(PC; パーソナルコンピュータ)の登場に伴って「普通の人」がパソコンを使うためにはどうすれば良いのかというテーマが増え、さらにインターネットの登場に伴ってインターネット上のサービスを使いやすくしていくためにはどうすれば良いのかというテーマが増え、2000年代後半に入るとスマートフォンや、インターネット上の人々の活動、人々の創造活動の変化、人々のコミュニケーション方法の進化など、人類がどのようにコンピュータを利用していくのかということ全てがHCIのテーマとなるようになってきました。2010年代には本格的に人工知能技術(AI)を活用した「賢い」コンピュータの実現に向けての研究うが盛んになり、現代においては人だけではなく、人と生活を共にする動物達がどのようにコンピュータを使うのか、なども研究テーマに含まれるようになってきました。

これらの研究は常に「人とコンピュータ」を扱う研究です。インタフェースは「人とコンピュータを繋ぐもの、その界面」を意味するものですが、HCIの大きな研究テーマの一つは「ユーザ(人を含む動物)がコンピュータを使うためのインタフェースを開発する」というものがあります。一般に「ユーザインタフェース」と呼ばれるものですが、これが無ければ我々はコンピュータを使うことができません。また、一般にコンピュータが使いにくいとすれば、それはインタフェースに問題があると考えることが自然です。私たちは「人々がコンピュータを使う際に、どのような困難があるのか。何をすることがユーザにとって難しいのか。」を、ユーザの観察や聞き取り調査によって明らかにした上で、必要な技術開発を行うという研究を行っています。これによって、ユーザにとっての「できない」を「できる」に変え、人々のQoLの向上に貢献することを目指しています。

現代においては、コンピュータと一言で言っても、いつも使うパソコン(PC)だけ考えてみても、グラフィカルユーザインタフェース(GUI)と呼ばれる基本的なインタフェースから、ウェブサイト/ウェブサービスのインタフェースなど数限りないインタフェースが存在します。また、スマートフォンやタブレットなど、パソコンよりも一回り小さいデバイスでは、キーボードやマウスではなくタッチ操作で利用することが前提であり、パソコンとは違うインタフェースが必要となります。さらに、Googleアシスタントのような音声対話システムでは音声インタフェースを使うことになります。街中でも見かけるようになった対話ロボットに関しては、将来的には人間と同様に音声と身体を利用したコミュニケーションが実現されることが期待されており、そのためのインタフェース技術の開発が続けられています。最近のテレビは色々な機能がありますが、それらをリモコンから操作するためには、更なる改善が必要だと感じることも多いでしょう。

当研究室ではこれらのインタフェースの発明と実装、または改善に取り組んでいます。まだ誰も経験したことの無いインタラクションを発明し、世の中に発信していく。当研究室では、現在は特に以下のようなテーマに注目して研究を進めています。

SCAN: Indoor Navigation Interface on a User-Scanned Indoor Map

Kenji Suzuki, Daisuke Sakamoto, Sakiko Nishi, and Tetsuo Ono

21st International Conference on Human-Computer Interaction with Mobile Devices and Services (MobileHCI '19)

We present an indoor navigation system, SCAN, which displays the user's current location on a user-scanned indoor map. Smartphones use the global positioning system (GPS) to determine their position on the earth, but it does not work in interior environments. SCAN uses indoor map images scanned by a smartphone camera and displays the user's position on the indoor map while they move around a floor. It tracks the user's position using an inertial measurement unit (IMU) on the smartphone. Camera calibration is required for precise navigation, but our system estimates the user's position based on a single landscape image. Results of our preliminary user study suggest that participants' experiences were similar to using outdoor GPS navigation systems.

Pressure-sensitive zooming-out interfaces for one-handed mobile interaction

Kenji Suzuki, Ryuuki Sakamoto, Daisuke Sakamoto, and Tetsuo Ono

20th International Conference on Human-Computer Interaction with Mobile Devices and Services (MobileHCI '18)

We present new alternative interfaces for zooming out on a mobile device: Bounce Back and Force Zoom. These interfaces are designed to be used with a single hand. They use a pressure-sensitive multitouch technology in which the pressure itself is used to zoom. Bounce Back senses the intensity of pressure while the user is pressing down on the display. When the user releases his or her finger, the view is bounced back to zoom out. Force Zoom also senses the intensity of pressure, and the zoom level is associated with this intensity. When the user presses down on the display, the view is scaled back according to the intensity of the pressure. We conducted a user study to investigate the efficiency and usability of our interfaces by comparing with previous pressure-sensitive zooming interface and Google Maps zooming interface as a baseline. Results showed that Bounce Back and Force Zoom was evaluated as significantly superior to that of previous research; number of operations was significantly lower than default mobile Google Maps interface and previous research.

機械学習 / Machine Learning (ML)

人工知能 / Artificial Intelligence (AI)

スマートフォンやスマートウォッチなどの最新のユーザインタフェースだけでなく、音声対話システム、ロボットやエージェントなど、人とインタラクションするありとあらゆるシステムで機械学習や人工知能技術が使われています。当研究室で実施している研究においても、多くの研究で機械学習や人工知能技術を用いており、ユーザインタフェースやインタラクションに関する研究は機械学習や人工知能技術のアプリケーション、つまり実際にそれらの技術を使う場面を扱う研究領域であると言えます。当研究室においては人を中心としたインタラクティブシステムの研究を行っていますが、この中でも機械学習・人工知能技術を使いやすくしていく研究や、機械学習・人工知能技術を使って、使いやすいインタラクティブシステムを開発する研究に力を入れています。

以降の研究事例にも含まれますが、例えば人の身体の動作を利用するジェスチャ入力や、VR/AR/MRでのインタフェース開発においては常に機械学習技術を利用しています。ロボットやエージェントに関する研究についても、例えば自然言語処理やコンピュータビジョン(CV)による物体認識技術を利用して高度なインタラクションを実現しています。さらに、人々の仕事を自動化するようなデジタルトランスフォーメーション(DX)に関しては、基本的にユーザインタフェースに関する研究であると言えますが、ここではつまり人々の作業を自動化するための人工知能技術を使ったユーザインタフェースの研究開発を行っていると言えます。

当研究室においては機械学習・人工知能技術の応用としてのアプリケーション開発を主に研究をしていますが、これに限らず機械学習・人工知能技術の基礎研究についても行ってきています。それぞれの研究では機械学習・人工知能技術を使用しているとは明言していませんが、それぞれの研究に関して「どんな機械学習・人工知能技術を使っているのだろう」とか「どうやれば同じインタフェースを機械学習・人工知能技術を使って再現できるだろう」という観点で以降の研究事例を見て貰えれば、みなさんの研究テーマ選定にも役に立つのではないかと思います。

スキーポールによる携帯端末操作に向けたユーザ定義型ジェスチャの設計と認識

岡田 友哉, 坂本 大介, 小野 哲雄

情報処理学会論文誌 62 (2)

本研究ではアウトドアアクティビティとしてのスキーに注目し,スキーポールを入力デバイスとしたジェスチャ入力手法を提案する.まず,複数人のスキー経験者にモバイルデバイス操作に適したジェスチャを考案してもらうことでユーザ定義型ジェスチャを設計した.設計したジェスチャの認識を行うため,ポールのグリップ部分の下に加速度,ジャイロセンサを装着し,そこから得られるセンサデータを利用するジェスチャ認識器を畳み込みニューラルネットワーク(CNN)で実装した.ジェスチャ実行時のデータを収集し,識別実験を実施した結果,ランダムに選択されたデータによって学習したときの正解率は約96.5%であり,1人のユーザのデータをテストデータとし,他のユーザのデータで学習したときの平均正解率は約85.8%であった.また,実際のスキー中の誤認識率を確認するためにスキー場にてデータを収集し,ジェスチャデータとの識別を行った結果,約99.3%の正解率でスキー滑走時とジェスチャ入力時の認識が可能であった.

Designing Hand Gesture Sequence Recognition Technique for Input While Grasping an Object

Sho Mitarai, Nagisa Munekata, Daisuke Sakamoto, Tetsuo Ono

Transactions of the Virtual Reality Society of Japan 26 (4)

In this paper, we propose a hand gesture sequence recognition technique for human–computer interactions wherein a user grasps an object. Our aim is to develop a technique which can recognize input in the form of various grasp types by recognizing their gesture sequence. We introduce a prototype using electromyography signals and report the results of a user study to validate the proposed technique for interactions in hands-busy situations and evaluate the recognition accuracy of the user gestures. The results demonstrate that our proposed technique showed 93.13% average accuracy for basic grasp types according to a classic taxonomy of grasping. We also discuss the findings of the user study and perspectives for the practical application of the proposed technique.

バーチャルリアリティ / Virtual Reality (VR)

オーグメンテッドリアリティ / Augmented Reality (AR)

ミクストリアリティ / Mixed Reality (MR)

Facebookが社名をMetaに変更しVRに注力する姿勢を示したり、主要なビッグテック(Google, Apple, Microsoft等)がARやMR用のヘッドセットを開発・販売するなど、VRだけでなくAR/MRも社会への普及のフェーズに入ってきたと言えます。VR、AR、MRを総称してXRと呼ぶことがありますが、このXR環境においてはマウスやキーボードを使うことは想定されておらず、身体の動作を利用したり、音声による操作を想定したインタラクションが検討されてきています。当研究室では、このようなXRにおける入力技術、特にユーザインタフェースやインタラクションデザインに関する研究を行ってきています。

従来のXRに関する研究は仮想世界への「没入感」を増幅するためにディスプレイに関する技術の研究が行われてきました。このディスプレイは、液晶ディスプレイのような視覚的な表示デバイスだけではなく、主要なゲーム機のコントローラに搭載されている振動デバイスなどによるハプティックフィードバックを代表する触覚提示デバイス、匂いを提示するデバイスや、最近では味を提示するデバイスなど、人の五感を刺激する技術やデバイスを意味します。現在でもこれらのXRにおけるディスプレイや表現に関する研究は数多く行われていますが、一方でXRの普及には「普通の人が普通にXR環境で作業ができる環境」が必要であり、そのためには「普通にXR環境を使うことができるようにする」ためのインタフェースに関する研究が必要となります。

当研究室においては、このようなXR環境での新しいインタラクションの提案や、ユーザインタフェースに関する研究を行ってきています。

Kuiper Belt: Utilizing the “Out-of-natural Angle” Region in the Eye-gaze Interaction for Virtual Reality

Myungguen Choi, Daisuke Sakamoto, and Tetsuo Ono.

CHI Conference on Human Factors in Computing Systems (CHI '22)

The maximum physical range of horizontal human eye movement is approximately 45°. However, in a natural gaze shift, the difference in the direction of the gaze relative to the frontal direction of the head rarely exceeds 25°. We name this region of 25° − 45° the “Kuiper Belt” in the eye-gaze interaction. We try to utilize this region to solve the Midas touch problem to enable a search task while reducing false input in the Virtual Reality environment. In this work, we conduct two studies to figure out the design principle of how we place menu items in the Kuiper Belt as an “out-of-natural angle” region of the eye-gaze movement, and determine the effectiveness and workload of the Kuiper Belt-based method. The results indicate that the Kuiper Belt-based method facilitated the visual search task while reducing false input. Finally, we present example applications utilizing the findings of these studies.

Interactive 360-Degree Glasses-Free Tabletop 3D Display

Motohiro Makiguchi, Daisuke Sakamoto, Hideaki Takada, Kengo Honda, and Tetsuo Ono.

32nd Annual ACM Symposium on User Interface Software and Technology (UIST '19)

We present an interactive 360-degree tabletop display system for collaborative work around a round table. Users are able to see 3D objects on the tabletop display anywhere around the table without 3D glasses. The system uses a visual perceptual mechanism for smooth motion parallax in the horizontal direction with fewer projectors than previous works. A 360-degree camera mounted above the table and image recognition software detects users' positions around the table and the heights of their faces (eyes) as they move around the table in real-time. Those mechanics help display correct vertical and horizontal direction motion parallax for different users simultaneously. Our system also has a user interaction function with a tablet device that manipulates 3D objects displayed on the table. These functions support collaborative work and communication between users. We implemented a prototype system and demonstrated the collaborative features of the 360-degree tabletop display system.

マルチモーダルインタフェース

VR環境では通常、ヘッドマウントディスプレイ(HMD)と呼ばれるヘッドセットを着用するか、AR/MRでは眼鏡型のディスプレイを通じてXR環境を体験します。この際、特にVR環境ではHMDで視界が遮られてしまうために、マウスやキーボードを使うことができないどころか、スマートフォンやタブレット端末で普通に使われるようになったタッチ操作を行うこともできません。AR/MR環境では実世界に映像が重畳表示されるため、デバイスを見ることはできますが、しかしAR/MRは座って利用するよりは立ちながら、移動しながらの利用を前提としているため、手に何らかのインタフェースを持つことを想定していません。

ではどのようにXR環境を利用するかというと、手や足、身体を使った動作、つまりジェスチャーを利用することが多くあります。手や足を中空で動かして特定のパターンを作り、それで操作をするとか、もしくは顔の表情を利用する、音声アシスタントのように音声で入力する、舌で入力するデバイスを利用するなど、全身をどのように活用していくのかという研究領域があります。当研究室では、このような全身を使うジェスチャ入力や、現在は特に視線入力に注目した研究を行ってきています。

パソコンやスマートフォンを使うことが苦手な人でも、Googleアシスタントのような音声対話インタフェースは利用できるというように、実は多くの人々はマウスやキーボード、タッチ操作が得意ではありません。XRは近未来的な印象がありますが、実はXRのほうがパソコンが苦手な人でも使えるデバイスに化ける可能性を秘めています。それを実現するためにも、これまでに実現されていない革新的なインタフェースが求められており、当研究室ではその創出に向けて日々議論を行っています。

Bubble Gaze Cursor + Bubble Gaze Lens: Applying Area Cursor Technique to Eye-Gaze Interface

Myungguen Choi, Daisuke Sakamoto, and Tetsuo Ono

ACM Symposium on Eye Tracking Research and Applications (ETRA '20)

We conducted two studies exploring how an area cursor technique can improve the eye-gaze interface. We first examined the bubble cursor technique. We developed an eye-gaze-based cursor called the bubble gaze cursor and compared it to a standard eye-gaze interface and a bubble cursor with a mouse. The results revealed that the bubble gaze cursor interface was faster than the standard point cursor-based eye-gaze interface. In addition, the usability and mental workload were significantly better than those of the standard interface. Next, we extended the bubble gaze cursor technique and developed a bubble gaze lens. The results indicated that the bubble gaze lens technique was faster than the bubble gaze cursor method and the error rate was reduced by 54.0%. The usability and mental workload were also considerably better than those of the bubble gaze cursor.

MyoTilt: a target selection method for smartwatches using the tilting operation and electromyography

Hiroki Kurosawa, Daisuke Sakamoto, and Tetsuo Ono

20th International Conference on Human-Computer Interaction with Mobile Devices and Services (MobileHCI '18)

We present the MyoTilt target selection method for smartwatches, which employs a combination of a tilt operation and electromyography (EMG). First, a user tilts his/her arm to indicate the direction of cursor movement on the smartwatch; then s/he applies forces on the arm. EMG senses the force and moves the cursor to the direction where the user is tilting his/her arm to manipulate the cursor. In this way, the user can simply manipulate the cursor on the smartwatch with minimal effort, by tiling the arm and applying force to it. We conducted an experiment to investigate its performance and to understand its usability. Result showed that participants selected small targets with an accuracy greater than 93.89%. In addition, performance significantly improved compared to previous tilting operation methods. Likewise, its accuracy was stable as targets became smaller, indicating that the method is unaffected by the "fat finger problem".